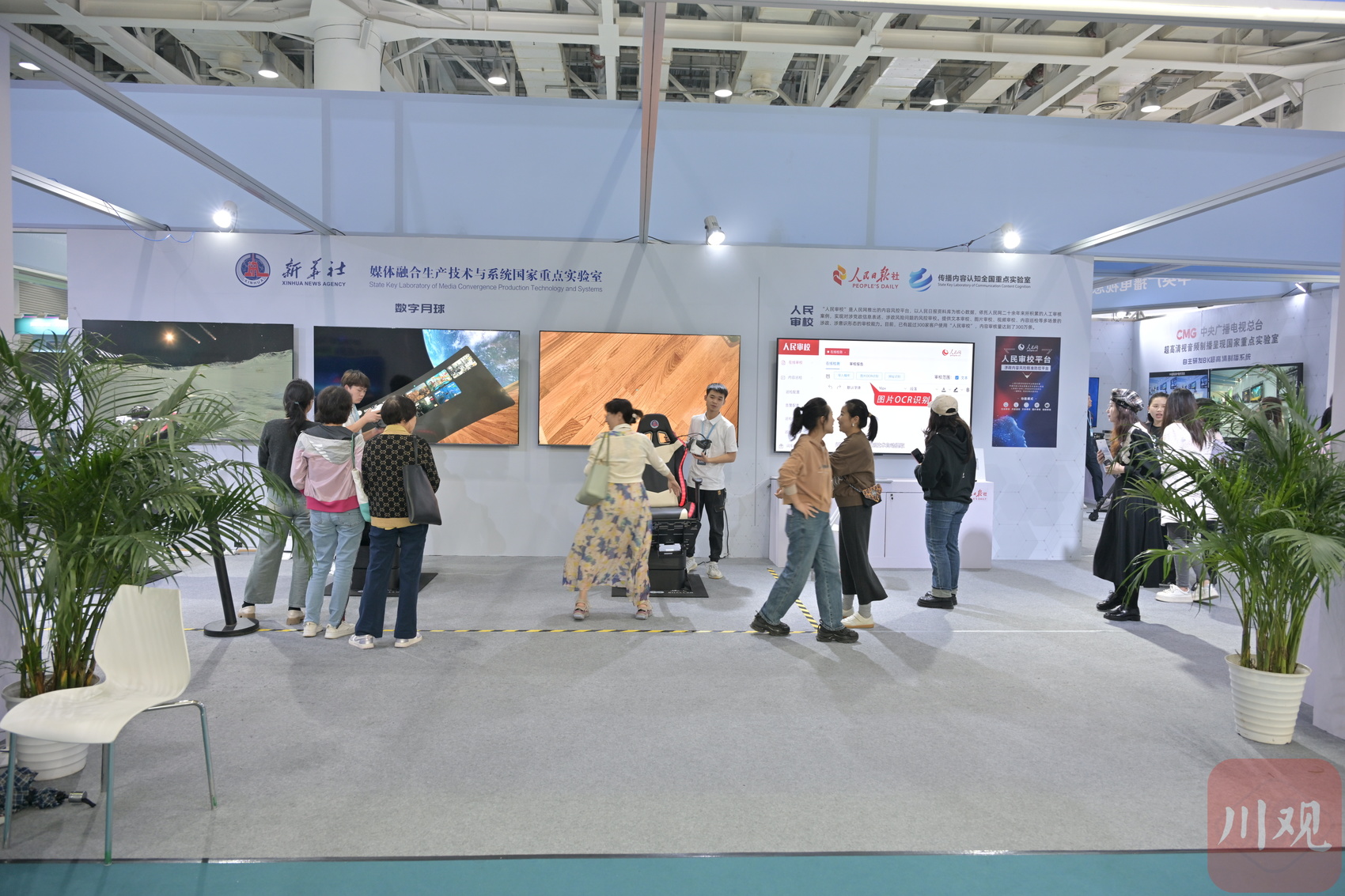

2024中国新媒体技术展现场。蒋京洲 摄

川观新闻记者 蒋京洲 发于湖南长沙

10月15日,在2024中国新媒体大会“融合创新 智慧传播”技术应用论坛上,中国传媒大学新媒体研究院院长赵子忠发布了《大模型深度赋能媒体智创融合——中国智能媒体创新发展报告(2023—2024)》(下称《报告》)。

在《报告》看来,对于媒体深度融合发展,人工智能技术浪潮带来的挑战与机遇并存。一方面,大模型落地传媒行业已成现实,产生了一批卓见成效的应用案例,在助力媒体深度融合发展、赋能媒体智创融合方面发挥作用。但同时,也面临着商业模式不成熟、内容合规和真实性存在担忧等问题。

人工智能大模型已经在智能媒体创新发展的哪些场景中得到应用?未来,大模型将以怎样的趋势和形态赋能智能媒体融合发展?对于这些问题,川观新闻记者结合大会见闻对《报告》内容进行了梳理。

赋能媒体发展,人工智能应用现状如何?

对于媒体机构而言,大模型首先可以应用在自身核心业务流程的智能化升级,促进“策采编审发评馈管”的全流程提质增效。

在与本次大会同步召开的2024中国新媒体技术展上,可以看到此类应用已有广泛落地。在中央广播电视总台、新华社展位上,AI审校、AI编辑等应用吸引观众驻足。同时,一些地方媒体也基于自身拥有的媒介资源训练私有模型,满足当地个性化的编审需求。

中央广播电视总台展出了其自主研发的8K超高清制播系统。蒋京洲 摄

从应用模式来看,《报告》提出了大模型问答、“副驾驶”和智能体三种模式。其中,大模型模式是指以自然语言进行人机交互,提供写作素材、灵感等。

“副驾驶”模式则是更加深度地融入媒体生产,人和机器参与到各自的工作流中共同发挥作用,最终达成合作。例如,川观新闻将数字人融入视频生产、封面新闻利用智媒云对传播数据进行智能分析等就属于此类应用。

在智能体模式下,人工智能被赋予了更大的自主性和独立性,人类更多的扮演监督和管理者的角色。记者在星图比特的展位上看到,该公司研发的大模型已经能够自主挖掘热点线索并智能生成多模态媒体产品。但同时,由于此类应用模式所带来的内容合规等问题,许多媒介机构对此仍持审慎态度。

在《报告》看来,大模型持续为媒体行业在生态拓展、链接用户等方面赋能。特别是从通用大模型到行业垂类大模型,人工智能所提供的服务更加精准,个性化更加突出。

但《报告》同时也指出,大模型落地传统行业仍要面临数据合规、内容安全、业务融合、落地成本等方面的问题。特别要指出的是,当下如何利用大模型赋能媒体融合的路径尚不明晰。对主流媒体而言,对通用大模型采取“拿来主义”并不可行,打造安全可控的媒体大模型技术底座才是破局之道。

展望未来趋势,媒体与人工智能如何互促?

《报告》认为,推动高质量语料数据库建设助力价值对齐,既是媒体行业推进人工智能大模型落地应用的优势所在,也能助力人工智能行业发展,保障大模型健康,是未来行业应用落地的一个重要趋势。

俗话说,“种瓜得瓜”,大模型价值对齐与语料库关联紧密。媒体在自身拥有的高质量语料数据集上具有天然优势,许多媒介机构已开始建设自有语料数据库,以用于模型训练、价值对齐等应用。

人民网汇集各方资源建设原始语料、重点领域语料和重点问答语料等在内的“主流价值语料库”,协助各类生成式AI系统加速合规达标。川观新闻也于近日宣布,四川省情语料库“若水”正式上线,将为媒体领域大模型相关应用及智库服务提供强力支撑、为各类大模型提供安全语料支撑、知识增强服务、助力各类人工智能应用实现主流价值观对齐。

新华社、人民网分别展出了其基于VR开发的数字月球项目和智能审校系统。蒋京洲 摄

此外,从大语言模型到多模态大模型应用,也将在未来加速媒体生产视频化、全息化转型。《报告》认为,由于多模态大模型直接对标内容生产的核心环节,能够深度参与视听产业链从内容创作到分发,再到用户交互和市场分析的全流程,预期可为其带来革命性变化。

此次展会上,中央广播电视总台、湖南广播影视集团等媒体机构展位上,已经展出了完全由AIGC生成的短视频作品,已凸显出人工智能技术在影视创作生态领域的巨大潜力。

智能体建设未来也将不断涌现,变革人机交互形态。《报告》认为,目前智能体类的产品功能还比较简单,远未达到直接面对目标任务,开展自主记忆、推理、规划和执行的能力水平,过程仍需大量人工介入。未来,媒体机构可通过战略规划、技术赋能与应用创新,开拓智能体蓝海市场,探索与用户链接的新形式。

最后,《报告》认为,基于大模型和硬件技术的发展,端侧大模型将越来越多落地。相较于云侧部署的大模型,端侧部署通过直接运行在本地硬件上,能给用户带来更加安全、及时和个性化的智能服务体验,由此推动“万物皆媒”向“万物皆智媒”的方向发展。

【未经授权,严禁转载!联系电话028-86968276】