日前,OpenAI公布一项研究成果:由哈佛医学院和斯坦福大学组成的科研团队,在医学诊断领域深入评估OpenAI的o1-preview模型,发现其比人类医生更擅长诊断棘手的医疗案例。相关消息引发了全球关注,医生真的在不久的将来会被取代吗?

o1-preview诊断正确率近8成

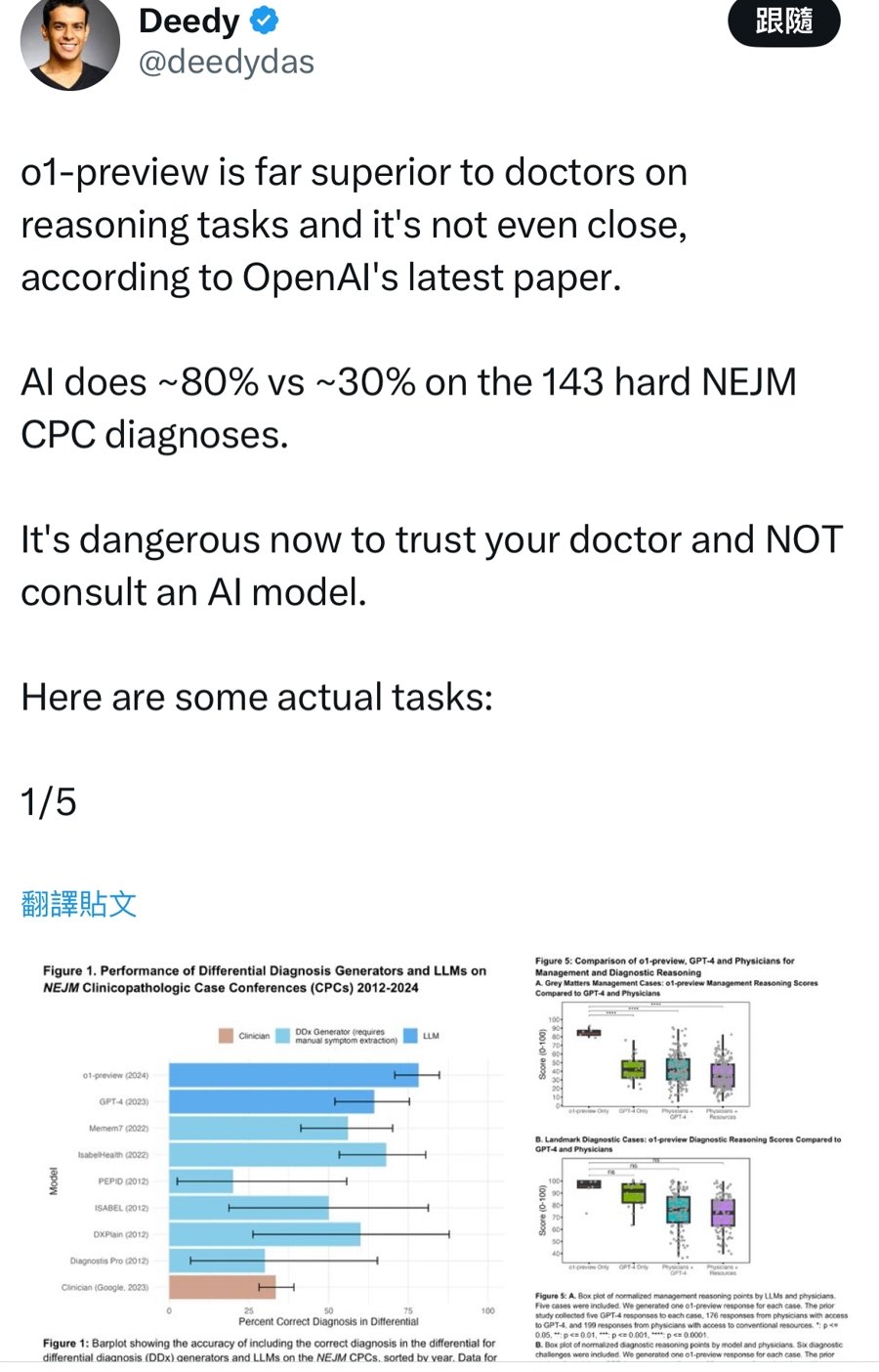

@deedydas在原文中说,“根据(关于)OpenAI的最新论文,o1-preview在推理任务上远远优于医生,甚至天壤之别。AI对143项困难的NEJM CPC诊断结果分别为约80%至30%。现在相信你的医生而不咨询人工智能模型是危险的。”据悉,自上世纪50年代以来,评估鉴别诊断生成器的首要标准是由《新英格兰医学杂志》(NEJM)发表的临床病理学会议(CPCs)病例,因此这也是评估o1-preview的首选基准。截至发稿前,该言论已引来107万次的浏览量。

根据研究报告,o1-preview正确诊断了78.3%的测试案例,在70个特定案例的对比测试中,准确率高达88.6%,显著优于其前身GPT-4的72.9%。此外,使用医学推理质量评估标准量表R-IDEA,o1-preview在80个案例中取得了78个满分。同时,经验丰富的医生在28个案例中获得满分,住院医生则仅为16例。而在25位专家设计的复杂案例中,o1-preview得分高达86%,是使用GPT-4的医生(41%)和使用传统工具的医生(34%)的两倍有余。

不过,研究人员承认该测试存在局限性,部分测试案例可能包含在o1-preview的训练数据中,且测试主要集中于系统单独工作,并未充分考虑其与人类医生协同工作的场景;此外,o1-preview建议的诊断测试成本高昂,在实际应用中存在局限性。

医学是科学,也是“人”学

这并非AI与医生的首次“对决”。此前,在医学顶刊《美国医学会杂志》(JAMA)等期刊上,也曾有研究指出大语言模型在诊断基准测试中超越了人类,包括医科学生、住院医师和主治医师。这是否意味着o1-preview在医学上已全面超越人类?

“AI确实在病例诊断的初步筛选、初诊环节具有很强的辅助功能,但无论是现在,或是可以预见的将来,它都仍旧没有完全进行决策的能力。”上海市第一人民医院副院长、放射科学科带头人王悍谈到,“无可否认的是,成熟的AI模型能力应该与住院医师是可以抗衡的,其优势在于完成重复性、细致度高的工作,比如肺小结节在体检场景中的筛查、心脑血管的重建。以往,大多数此类工作由住院医师人工扫描完成,大约耗时20分钟,现在基于AI的四维重建最快只需按秒计算,大大节省了临床医师的时间,还能减少患者的不适。”另一方面,AI也有劣势:所有的诊断均应该建立在可靠、可重复的基础上,目前尚无样本量和覆盖面足够大且可靠的通用型模型,不同人种、国家、性别、年龄、文化水平等变量参数都可能造成评估的谬误,“因为医学不仅是科学,也是‘人’学。”

王悍说,以我国传统中医药为例,望、闻、问、切的诊疗流程缺一不可,即便如今也有中医领域的AI软件及模型开发,如根据舌苔的疾病评估,但仍基于图形化的固定模式,“它或许还不同于X光、CT影像学报告,这与医患面对面,有热度的触诊是不同的。”

其实,AI在辅助决策中的准确率现阶段仍取决于患者的“标准化”,但其心理因素、经济水平乃至社会关系都可能在真实的治疗场景中对方案产生影响,“AI或许可以完成多学科团队(MDT)对于单纯病理症状的评估并给出建议,但患者最终选择的方案,仍需医者以同理心从‘模棱两可’的选项中帮助拍板。”

好医生应学会向AI借力

在王悍看来,虽然AI模型较难完全取代医生,但主动学习AI同时对其保持不依赖的心理,才是未来从事医疗领域的不二法则。“如果学不会向AI借力,在未来更精准、个性化的诊疗趋势中,医生会浪费更多宝贵的精力;但若过分盲信AI,就会成为‘被淘汰者’。”他直言。

11月30日,中国互联网络信息中心发布了《生成式人工智能应用发展报告(2024)》,截至今年6月,我国生成式人工智能产品的用户规模已达2.3亿人。由清华大学智能产业研究院团队打造的首家“AI医院”(Agent Hospital)预计将于2025年上半年对公众开放,医疗或将在不远的将来成为AI渗透生活的主要途径之一。

在上海,11月末也公布了首批5个医疗应用场景,包括中山医院AI电子病历辅助书写、AI医健助手,东方医院医生伴侣、科研助理及上海电信的就医小帮手等。正如东方医院AI医学大模型Med-Go创始人、急诊重症医学科主任张海涛所说,精准高效的可解释性医学回复内容,是医学模型的核心竞争力,也是赋能医学提高临床应用的重中之重,“AI来源于医生,也服务医生与患者,让其助力人才队伍的高效培养与升级,将最终为患者带来精益求精的医疗体验。”

【未经授权,严禁转载!联系电话028-86968276】

AI诊断比医生还准,我仿佛看到了未来医院的新标语:欢迎来到未来医疗,您的健康由AI守护!不过,话说回来,AI虽好,但人文关怀的温度,可是机器永远学不来的。

让ai为我们服务

场景